Korporacje łączą siły celem wyznaczenia standardów dla bezpiecznej AI

Utworzenie Coalition for Secure AI zostało ogłoszone wczoraj w trakcie Aspen Security Forum. Rzeczona koalicja jest otwartą inicjatywą, której celem jest dawanie developerom pracującym nad sztuczną inteligencją wskazówek i narzędzi niezbędnych do wdrażania jej w bezpieczny sposób. Jak możemy przeczytać na stronie Oasis Open, „będzie ona wspierać ekosystem współpracy w celu udostępniania metodologii open source, znormalizowanych ram i narzędzi”.

Koalicja na rzecz bezpiecznej sztucznej inteligencji

Koalicja na rzecz bezpiecznej sztucznej inteligencji jest zrzeszeniem wielu przedsiębiorstw, wśród których znajdują się giganci technologiczni pokroju Google, IBM, Microsoftu, Intela, PayPala i Nvidii, będący zarazem pomysłodawcami i twórcami opisywanej inicjatywy.

Jak już zostało wspomniane, u podłoża CoSAI leży idea bezpiecznej budowy oraz integrowania systemów sztucznej inteligencji. Głównym zadaniem tego projektu jest opracowanie kompleksowych środków bezpieczeństwa, mając na uwadze wszelkie potencjalne zagrożenia związane z AI, do których grona zaliczyć można m.in. kradzież modeli, zatruwanie danych, ataki inferencyjne oraz wstrzykiwanie promptów.

Coalition for Secure AI zostało przemyślane jako otwarta inicjatywa, aczkolwiek znalazło się w niej miejsce na Radę Zarządczą Projektu odpowiedzialną za nadzór programu oraz Techniczny Komitet Sterujący, w skład którego wchodzą eksperci ds. AI związani z branżą i środowiskiem akademickim.

Powody stojące za uformowaniem koalicja na rzecz bezpiecznej sztucznej inteligencji są raczej jasne, aczkolwiek odpowiednie wytłumaczenie znalazło się także w przytoczonym wcześniej wpisie:

Sztuczna inteligencja (AI) szybko przekształca nasz świat i ma ogromny potencjał do rozwiązywania złożonych problemów. Aby zapewnić zaufanie do sztucznej inteligencji i napędzać odpowiedzialny rozwój, kluczowe znaczenie ma opracowanie i udostępnianie metodologii, które utrzymują bezpieczeństwo na pierwszym planie, identyfikują i łagodzą potencjalne luki w systemach sztucznej inteligencji oraz prowadzą do tworzenia systemów, które są bezpieczne już na etapie projektowania.

Przedstawiciele CoSAI zapewniają, że są zaangażowani we współpracę z podobnymi organizacjami skupionymi na opracowaniu bardziej bezpiecznej sztucznej inteligencji. Na początku swojej działalności Coalition for Secure AI skupi się przede wszystkim na opracowaniu najlepszych praktyk i ram oceny ryzyka dla bezpieczeństwa sztucznej inteligencji i sposobów zapewnienia ochrony łańcucha dostaw oprogramowania dla systemów AI, aczkolwiek niewykluczone, że zakres działalności koalicji poszerzy się wraz z upływem czasu.

Czytaj dalej

-

3

3Popularny aktor głosowy sprzeciwia się demonizowaniu AI w branży gier. „AI może tworzyć treści, ale nie wykreuje sztuki”

-

5

5Weteran BioWare’u o tym, co może przekonać graczy do AI. „Wiele mediów już jest bezdusznych”

-

17

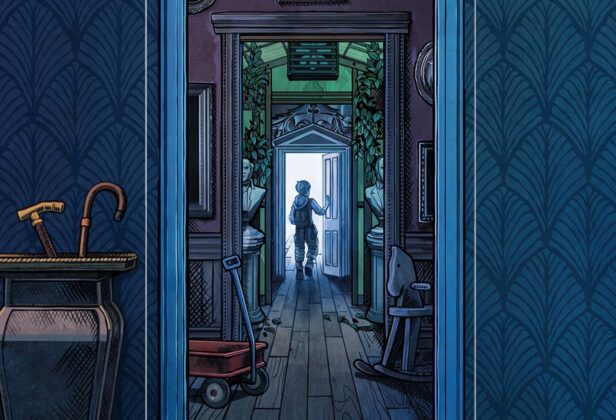

Twórca Blue Prince oskarżany o użycie AI do produkcji gry. Wydawca temu zaprzecza: „To rezultat 8 lat pracy napędzanej wyobraźnią i kreatywnością”

-

10

10Twórcy Battlefielda 6 oskarżani o korzystanie z AI do tworzenia przedmiotów kosmetycznych. Gracze znaleźli karabin z… dwiema lufami