ROG Strix GeForce RTX 4090 OC Edition 24 GB – test potwora

Seria RTX 40 to następca generacji powszechnie uznawanej za straconą. „Trzydziestki”, jak pewnie pamiętacie, za normalne pieniądze dostępne były jedynie na samym początku, potem zaś ich ceny, cóż, eksplodowała. Pandemia, przerwane łańcuchy dostaw, olbrzymie zapotrzebowanie związane z boomem na kryptowaluty – wszystko to sprawiło, że GPU nie dało się kupić za rozsądne kwoty. Zmieniło się to dopiero niedawno. Tylko po to, żebyśmy się przekonali, iż tanio to jednak już było, o czym zresztą pisałem jakiś czas temu. Za nową serię układów, wbrew płonnym nadziejom, musimy płacić jak za zboże. Najdroższa zaś, bo wyceniona oficjalnie na ok. 10 tys. złotych, jest karta RTX 4090.

Ada, to nie wypada

Nowa seria, nowa architektura – tym razem nosząca imię brytyjskiej matematyczki, dość powszechnie uznawanej również, ze względu na swoje prace, za pierwszą programistkę. Całkiem trafny patronat, zważywszy, że najświeższe karty Nvidii – co wprost wynika z ich wewnętrznej budowy – potrafią wziąć na swe barki jeszcze więcej obliczeń związanych z technologią śledzenia promieni światła i maszynowym przetwarzaniem obrazu. Innymi słowy, suche liczby wskazują, że seria RTX 40 będzie błyszczeć, jeśli chodzi o ray tracing i DLSS we wchodzącej do gry wraz z rzeczonymi kartami trzeciej już edycji maszynowego upscalingu. Nim jednak do tego przejdziemy, opowiedzmy trochę o samej karcie.

Chip AD102 został stworzony w procesie technologicznym TSMC 4 nm i choć pod względem ogólnej budowy jest podobny do poprzedniej generacji, to mieści w sobie aż 76,3 mld tranzystorów (czyli ponaddwukrotnie więcej niż poprzednio!) w przeszło 18 tys. rdzeni CUDA. Ogółem na pełny chipset składa się 12 bloków GPC – Nvidia jednak najwyraźniej zostawiła sobie miejsce na wersję Ti swej najmocniejszej karty, gdyż RTX 4090 wykorzystuje ich 11, co przekłada się na 16 384 procesory CUDA, 512 jednostek teksturujących, 128 jednostek renderujących, 128 rdzeni RT oraz 512 rdzeni Tensor. Podstawą działania karty są znajdujące się w blokach GPC nowe jednostki SM (Streaming Multiprocessors) nawet dwukrotnie bardziej wydajne – jak podkreśla Nvidia – od poprzedników przy jednoczesnym obniżeniu zapotrzebowania na energię (ogólna moc obliczeniowa wynosi w tym przypadku 83 TFLOPS).

Rewelacyjna wydajność za niebotyczną cenę.

Tradycyjnie już pojawiły się również rdzenie RT, tym razem trzeciej generacji. Korzystając z nowych silników Opacity Micromap i Displaced Micro-Meshes oraz związanych z nimi optymalizacji przetwarzania, potrafią przyspieszyć proces tworzenia scen z realistycznie odtworzonym światłem nawet dwukrotnie, co przekłada się na ogólną moc obliczeniową wynoszącą 191 TFLOPS.

Dodatkowe klatki „z powietrza”

Jest i następca DLSS-a. Trzecia jego edycja to technologia opierająca się z jednej strony na sztucznej inteligencji i przygotowaniu gier po stronie produkcyjnej, z drugiej zaś na odpowiednim zapleczu w postaci rdzeni Tensor czwartej generacji – przystosowanych właśnie do wspierania DLSS-a 3 i przeszło dwukrotnie mocniejszych od poprzedników (1,3 PFLOPS ogólnej mocy obliczeniowej).

Jest to możliwe dzięki zastosowaniu nowych technologii w postaci m.in. analizującego różnice pomiędzy dwiema następującymi po sobie klatkami Optical Flow Acceleratora. Powstał on, by wychwytywać przesunięcia pikseli (z uwzględnieniem np. cieni czy efektów cząsteczkowych) i w ten sposób wspierać technologię AI Frame Generator, która już całościowo odpowiada za to, że między wspomnianymi wyrenderowanymi w standardowy sposób klatkami obrazu pojawiają się te w całości stworzone przez sztuczną inteligencję – a więc bez udziału tradycyjnie pojmowanego GPU czy CPU. Oprócz tego DLSS – podobnie jak poprzednio – pracuje również nad wspomaganym przez AI zwiększaniem rozdzielczości pojedynczych, surowych klatek.

Skutek? Nvidia chwali się, że – statystycznie rzecz ujmując – w rozdzielczości 4K z aktywnym DLSS-em 3 na każde osiem widocznych na ekranie pikseli aż siedem jest stworzonych przez sztuczną inteligencję. Tym samym więc DLSS, pierwotnie opracowany po to, by wspomóc bardzo wymagający pod względem obliczeń rendering z ray tracingiem, wyrasta (oczywiście w obsługiwanych tytułach) na główną siłę napędową i technologię odpowiadającą za niebotyczny wręcz przyrost wydajności.

A co poza samym chipem? W karcie RTX 4090 sekundują mu 24 GB pamięci GDDR6X 21 Gbps korzystającej z magistrali 384-bit. Urządzenie używa PCI Express 4.0, TDP zaś określono na 450 W. Choć tutaj nowy RTX jest podobny do 3090 Ti, to wszędzie indziej widać wyraźny postęp, co oczywiście przekłada się na oszałamiające wyniki, jeśli chodzi o wydajność karty.

Potwór w grach

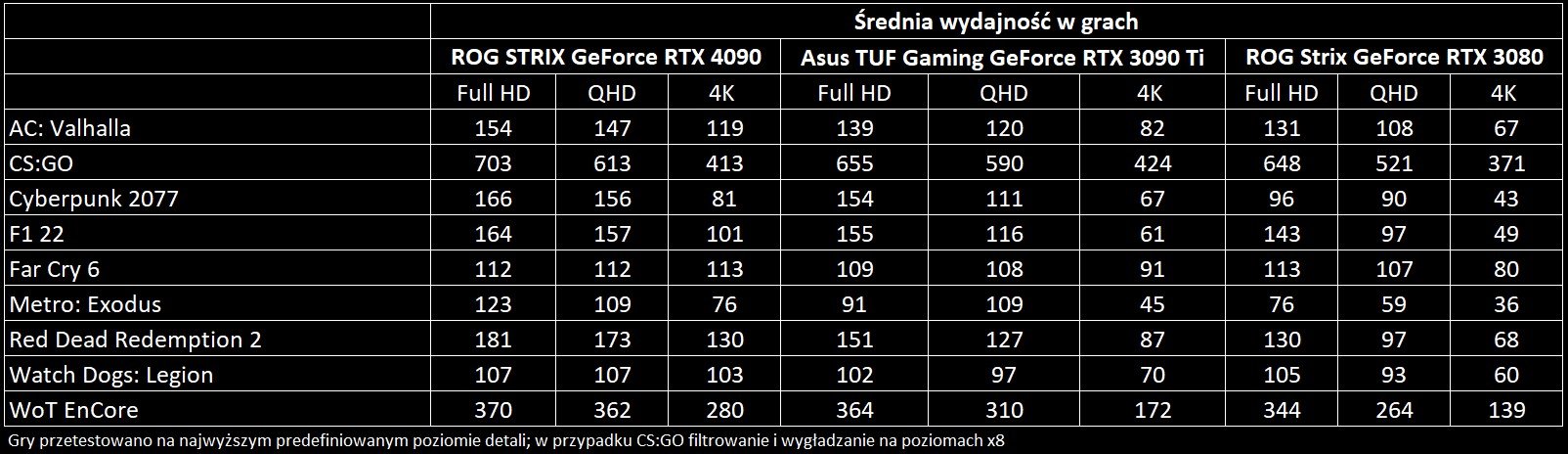

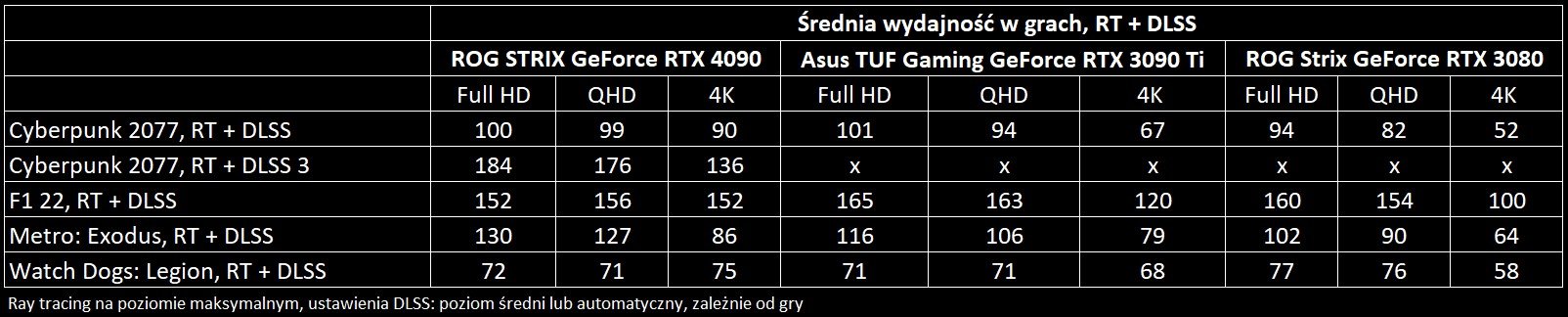

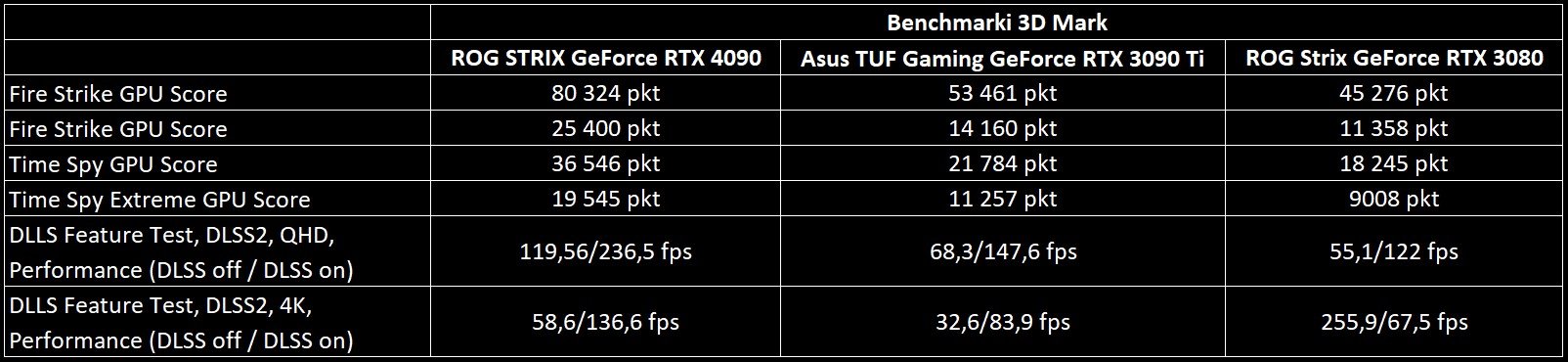

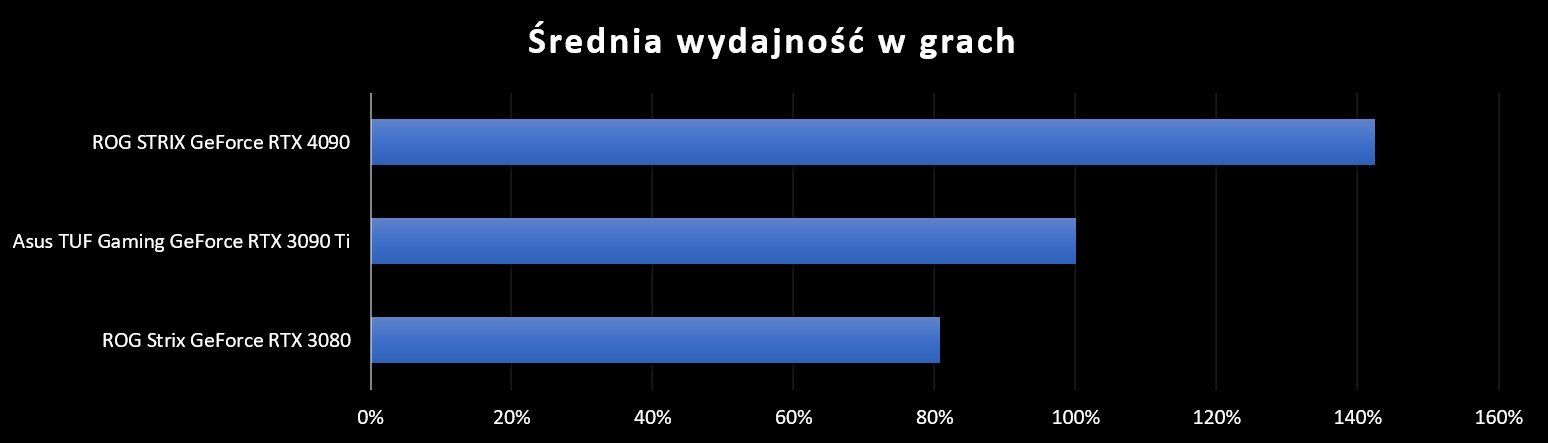

Co tu dużo mówić: to najszybsza karta w historii grania na pececie. RTX 4090 w stosunku do poprzedniej generacji nie pozostawia wątpliwości, że skok wydajności w każdym wręcz aspekcie jest niezwykle duży. Karta dubluje osiągi RTX-a 3080, a w porównaniu do najmocniejszego modelu poprzedniej generacji, czyli RTX-a 3090 Ti, możemy liczyć na wydajność wynoszącą od 124% do aż 168% możliwości wymienionej karty (nie licząc CS:GO, który w naszych testach wypadł tu i tu bardzo podobnie). Mówimy o surowej wydajności w rozdzielczości 4K.

Jeśli chodzi o DLSS i RT, to w przetestowanych przez nas tytułach największa różnica na korzyść RTX-a 4090 pojawiła się w przypadku gry Cyberpunk 2077 i wynosiła ona 34% względem 3090 Ti. To jednak nie koniec – po aktywowaniu DLSS-a 3… wydajność wzrosła dwukrotnie. Do tematu „trójki” szerzej wrócimy za jakiś czas, jednak już teraz widać, że Nvidia naprawdę się postarała. Jeśli tylko wspomniana technologia wejdzie do powszechnego użytku – a wiele na to wskazuje – to karty serii RTX 40 będą po prostu wymiatać. Co nie znaczy, że obecnie jest źle – gdzie nie spojrzeć, tam olbrzymi skok wydajności nawet bez posiłkowania się DLSS-em 3. Brawa.

Nim jednak przejdziemy do omówienia kultury pracy, popatrzmy jeszcze na suche liczby. Najnowsze dziecko Nvidii i Asusa to sprzęt, który pozwoli pograć w Metro Exodus na ustawieniach grafiki extreme ze średnią wydajnością rzędu 76 kl./s w 4K, a gdy włączymy ray tracing i DLSS, uzyskamy przy tej samej liczbie pikseli aż 86 kl./s. Rzecz w sumie niebywała. W zasadzie nie licząc tego tytułu, wszystkie inne – bez DLSS-a – śmigają z wydajnością ok. 100 kl./s i więcej. Setki nie przebija jedynie Watch Dogs: Legion, któremu do tej granicy brakuje ledwie trzech klatek animacji. Wszystko to oczywiście w rozdzielczości 4K. A co z niższymi? Cóż, ta karta nie jest do tego przeznaczona i widać, że miejscami po prostu nie starcza jej CPU – kupowanie RTX-a 4090 mija się z celem, jeśli nie zamierzacie grać na ekranie 4K.

Kultura pracy

RTX 4090 zawitał u nas w wydaniu ROG Strix. To naprawdę wielki kawał kloca: grubość, określona przez producenta na 3,5 slotu, w połączeniu z pokaźną długością sprawiają, że pojawia się ryzyko, iż w typowej obudowie po prostu nie starczy miejsca – przeszkodą w zamontowaniu tego potwora mogą okazać się np. szuflady na dyski. Warto mieć ów fakt na uwadze, gdybyście rozważali zakup tego modelu. Chłodzenie jednak spełnia swoje zadanie wyśmienicie: maksymalna temperatura w trakcie testów wyniosła 64° i – co ważne – karta przy tym była cały czas stosunkowo cicha, pod maksymalnym obciążeniem ledwie szumiała.

Jeśli chodzi o pobór mocy, to dla całego zestawu wyniósł on szczytowo 748 W. W przypadku 3080 to 626 W, zaś RTX 3090 Ti włożony do tego samego komputera „zassał” 738 W. Uwaga: mowa tutaj o wartościach maksymalnych z całego cyklu testów, typowo było trochę mniej – wyraźnie to jednak pokazuje, że nowa generacja „wyciska” znacznie więcej przy podobnym zużyciu energii.

Pisząc o poborze mocy, nie sposób pominąć kwestii zasilania. W przypadku tradycyjnych zasilaczy karta wymaga czterech ośmiopinowych wtyczek, które podłączamy przez przejściówkę do gniazda 12VHPWR. Jak pokazują przykłady z sieci, ta ostatnia może się nagrzewać, w skrajnych przypadkach zaś wręcz topić. Problem ten jest co prawda raczej jednostkowy, ale warto wiedzieć, że się pojawia. I najwyraźniej dotyczy nie tylko samej przejściówki, ale i okablowania zasilaczy (odnotowano co najmniej jeden przypadek, kiedy zniszczeniu uległo oryginalne okablowanie wraz z gniazdem karty). U mnie jednak żadnych podobnych kłopotów nie było i konstrukcja Asusa chodziła jak marzenie: do ogólnej budowy karty nie mam żadnych zarzutów poza tymi oczywistymi i wymienionymi wyżej.

Cena…

Osoba, którą stać na taki zakup, będzie zadowolona. Równocześnie jednak – choć w zupełności zdaję sobie sprawę, iż RTX 4090 to nie jest model dla zwyczajnych zjadaczy polygonów – cena tak czy inaczej szokuje. Prawie 10 tys. złotych za model referencyjny to niestety znak tego, że – jeśli poczynania Nvidii nie spotkają się z mocną odpowiedzią konkurencji (a na taką, przynajmniej pod względem ceny, na szczęście się zanosi) – w pecetowej krainie tanio już było. Oczywiście to bardzo dobra karta, ba, najmocniejsza, jaką gracze kiedykolwiek widzieli, do tego naszpikowana nowościami z rewolucyjnym w założeniach DLSS-em 3 na czele. Nie zmienia to jednak faktu, że za tę kwotę można kupić cztery konsole najnowszej generacji lub po prostu jedną, ale za to z wyśmienitym, dużym telewizorem OLED i abonamentem na granie bez ograniczeń.

Podsumowując, to bez wątpienia piękna i piekielnie wydajna karta, do tego świetnie przygotowana pod względem technicznym przez Asusa w ramach hi-endowej linii ROG Strix. Wszystkie te zalety jednak bledną, gdy spojrzymy na paragon – w zakupie osobiście większego sensu nie widzę. Nie za takie pieniądze.

Cena: 12300 zł

Dostarczył: ROG

ROG STRIX GEFORCE RTX 4090 OC EDITION 24GB – PARAMETRY

Taktowanie GPU: 2610 MHz (Boost), 2640 MHz (OC Mode) • Pamięć: 24 GB GDDR6X • Przepustowość pamięci: 1008 GB/s • Zużycie energii (TDP): 450 W • Dodatkowe zasilanie: 4 × 8 pin + przejściówka lub 12VHPWR 1 × 12 pin • Gniazda: 2 × HDMI 2.1a, 3 × DisplayPort 1.4a • Chłodzenie: powietrzne, 3 × wentylator, 3,5 slotu • Inne: podświetlenie Aura Sync ARGB, rekomendowany zasilacz 1000 W • Wymiary: 357,6 × 149,3 × 70,1 mm • Waga: ok. 2,5 kg

[Block conversion error: rating]

Taa powodzenia z rachunkami za prąd przy graniu na tej karcie i z cenami za prąd jakie nam szykuje rząd na przyszły rok i kolejne lata 🙁

Nareszcie! Dziękuję za teścik.

Wygląda na to, że historia graczy jako klientów drugiej kategorii wobec kopaczy kryptowalut przenosi się również na nową generację RTXów. Ceny kładą na łopatki, ale z drugiej strony, to nie jest karta dla plebsu. Z trzeciej zaś, zapowiadane kwoty, jakie trzeba będzie wysupłać żeby stać się właścicielem 4080, który ma być bliższy zwykłemu śmiertelnikowi to jakiś kosmos – ceny niereferyncyjnych modeli przekraczają 2000 euro.

PS. Warto wspomnieć, że nowa technologia generowania „półklatek” nie współpracuje z v-syncem i pokrewnymi.

PS2. Czy druga tabelka z wydajnością nie powinna zawierać wyników z RT albo z DLSSem?

Chyba jest już dobrze ;). Na normalne ceny RTX-a 4080 nie ma co liczyć. Niestety, wygląda na to, że granie na PC stanie się bardzo drogie (szczególnie już na monitorach powyżej Full HD) i najrozsądniejszą alternatywą dla gier AAA będą konsole Microsoftu z abonamentem. Nadzieja jeszcze w AMD i w nadchodzącej serii Radeonów: oby okazały się naprawdę dobre, bo co mi po wyśmienitych kartach Nvidii, kiedy ich zakup po prostu nie ma sensu. Jak sobie przypomnę, że flagową GTX 280 swego czasu kupiłem za 1100 zł, to aż mnie skręca. Z ciekawości jakiś czas temu przeliczyłem tę kwotę, uwzględniając inflację – dziś to byłoby jakieś 1900 zł. Za najlepsze GPU na rynku. Kosmos.